Por Amós Toh – Human Rights Watch

La implosión de OpenAI, creador del chatbot viral de inteligencia artificial (IA) ChatGPT, en noviembre de 2023, ha intensificado los debates sobre cómo se debe gobernar la IA. Apenas unas semanas antes de que Sam Altman fuera despedido y rápidamente recontratado como director ejecutivo de la empresa, la Casa Blanca había anunciado nuevos estándares de seguridad para los desarrolladores de IA generativa, la tecnología en la que se basa ChatGPT. Los debates sobre los riesgos de la IA generativa también dominaron la primera cumbre de alto nivel sobre seguridad de la IA celebrada en el Reino Unido. Y el desacuerdo sobre qué restricciones deberían imponerse a la tecnología en rápido desarrollo casi descarriló la tan esperada regulación de la Unión Europea sobre la IA.

Esta preocupación por la IA generativa está eclipsando otras formas de toma de decisiones algorítmicas que ya están profundamente arraigadas en la sociedad y las lecciones que ofrecen sobre la regulación de la tecnología emergente. Algunos de los algoritmos que atraen menos atención son capaces de infligir el mayor daño; por ejemplo, los algoritmos que están entretejidos en el tejido de los servicios gubernamentales y dictan si las personas pueden permitirse alimentos, vivienda y atención médica.

En el Reino Unido, donde el Primer Ministro Rishi Sunak advirtió recientemente que “la humanidad podría perder completamente el control de la IA”, el gobierno ha cedido el control del sistema de asistencia social del país a algoritmos que a menudo reducen los beneficios de las personas de manera impredecible. El sistema, conocido como Crédito Universal, se implementó en 2013 para mejorar la eficiencia administrativa y ahorrar costos, principalmente mediante la automatización de los cálculos de beneficios y la maximización del “autoservicio” digital por parte de los solicitantes de beneficios.

Los crecientes costos de implementar el Crédito Universal han generado dudas sobre la promesa del gobierno de ahorrar costos. Este sistema en gran medida automatizado también está haciendo que el proceso de reclamar beneficios y apelar errores sea más inflexible y oneroso para las personas que ya luchan contra la pobreza.

Reino Unido, varios grupos de la sociedad civil y Human Rights Watch han descubierto que el sistema se basa en un algoritmo de prueba de recursos que tiende a calcular mal los ingresos de las personas y a subestimar la cantidad de apoyo en efectivo que necesitan. Las familias que son las más afectadas por el diseño defectuoso del algoritmo pasan hambre, se atrasan en el pago del alquiler y se endeudan. Sin embargo, Sunak no parece entender el costo humano de las fallas de la automatización, quien ha prometido que su gobierno no se “apresurará a regular” la IA.

Sunak también ha elogiado la IA como la “respuesta” a “tomar medidas drásticas contra los estafadores de prestaciones”, pero la experiencia de otros países europeos cuenta una historia diferente. En todo el continente, los gobiernos están recurriendo a elaborados sistemas de inteligencia artificial para detectar si las personas están defraudando al Estado, motivados por llamados a reducir el gasto público , así como por narrativas politizadas que afirman que el fraude a los beneficios se está saliendo de control. Estos sistemas aprovechan grandes cantidades de datos personales y sensibles, intentando sacar a la luz signos de fraude del origen nacional y étnico de las personas , los idiomas que hablan y sus antecedentes familiares y laborales, registros de vivienda, informes de deuda e incluso relaciones románticas .

Estas máquinas de vigilancia no han dado los resultados que esperaban los gobiernos. Las pistas de investigación señaladas por el algoritmo de detección de fraude de Dinamarca representan sólo el 13 por ciento de los casos que investigan las autoridades de Copenhague. Un algoritmo que el gobierno español adquirió para evaluar si los trabajadores están solicitando falsamente beneficios de licencia por enfermedad sufre de altas tasas de error ; los inspectores médicos que se supone que deben usarlo para investigar las solicitudes han cuestionado si es siquiera necesario.

Más importante aún, estas tecnologías excluyen a las personas del apoyo esencial y las seleccionan para ser investigadas basándose en estereotipos sobre la pobreza y otros criterios discriminatorios. En Francia, una investigación reciente de Le Monde encontró que la agencia de seguridad social del país se basa en un algoritmo de calificación de riesgos que tiene más probabilidades de activar auditorías de hogares con problemas de alquiler, familias monoparentales, personas con discapacidades y trabajadores informales . En 2021, el gobierno holandés se vio obligado a dimitir tras revelaciones de que las autoridades tributarias habían acusado erróneamente a hasta 26.000 padres de cometer fraude en prestaciones por hijos, basándose en un algoritmo defectuoso que señalaba desproporcionadamente a las familias de bajos ingresos y a las minorías étnicas como riesgos de fraude.

Los responsables políticos de la UE llegaron a un acuerdo el 8 de diciembre de 2023 para aprobar la Ley de Inteligencia Artificial, pero desde entonces el presidente francés, Emmanuel Macron, ha expresado su preocupación de que la regulación pueda obstaculizar la innovación . Incluso si el acuerdo se mantiene, es dudoso que la regulación imponga salvaguardias significativas contra los sistemas discriminatorios de detección de fraude, y mucho menos frene su propagación. Borradores anteriores de la regulación habían propuesto una vaga prohibición de la puntuación social de “propósito general”, invocando el espectro de un futuro distópico en el que las vidas de las personas se reducen a una única puntuación social que controla si pueden abordar un avión, obtener un préstamo, o conseguir un trabajo. Esto no capta cómo funcionan actualmente las tecnologías de calificación del riesgo de fraude , que tienen un propósito más limitado pero aún son capaces de privar a las personas de apoyo vital y discriminar a las poblaciones vulnerables.

Los despliegues dañinos de IA también se están acumulando en Estados Unidos, y el estancamiento legislativo está paralizando una acción muy necesaria. Muchos estados, por ejemplo, dependen del reconocimiento facial para verificar las solicitudes de prestaciones por desempleo, a pesar de informes generalizados de que la tecnología ha retrasado o negado erróneamente a las personas el acceso a la ayuda. Más de dos docenas de estados también han implementado algoritmos que están vinculados a recortes irracionales en las horas de atención domiciliaria de las personas bajo un programa de Medicaid que brinda apoyo para una vida independiente.

En 2017, Legal Aid of Arkansas desafió con éxito el algoritmo de Medicaid del estado, que reemplazó las evaluaciones de las necesidades de atención domiciliaria realizadas por enfermeras. El algoritmo redujo arbitrariamente las horas de atención domiciliaria asignadas a muchas personas mayores y personas con discapacidades, obligándolas a renunciar a comidas, baños y otras tareas básicas con las que necesitan ayuda.

Kevin De Liban, el abogado de Legal Aid que presentó la demanda, me dijo que el cambio a evaluaciones algorítmicas seguramente crearía dificultades porque, para empezar, muchas personas no tenían acceso a un apoyo adecuado. Cuando Arkansas implementó el algoritmo, también redujo el límite semanal de atención domiciliaria de 56 a 46 horas. “En el mejor de los casos, las personas con discapacidad tendrían dificultades para vivir de forma independiente”, afirmó De Liban. “Cuando el algoritmo asigna incluso menos horas que eso, la situación se vuelve totalmente intolerable y resulta en un inmenso sufrimiento humano”.

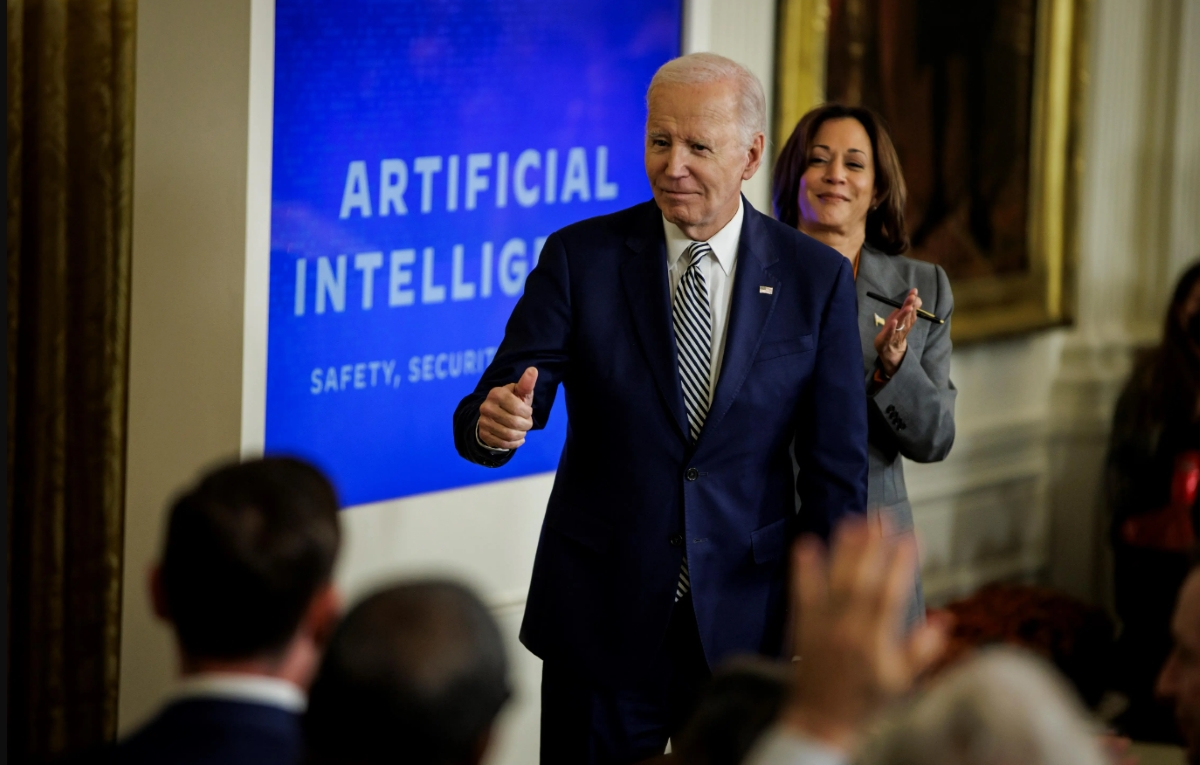

El Congreso ha propuesto una serie de proyectos de ley para regular estas tecnologías, pero la medida más concreta hasta ahora proviene de la Casa Blanca. Su reciente orden ejecutiva ordena a los desarrolladores de IA generativa que presenten resultados de pruebas de seguridad y a las agencias federales que establezcan pautas sobre cómo utilizan la IA. En particular, las agencias federales que supervisan Medicaid, la asistencia alimentaria y otros programas de beneficios deben elaborar directrices sobre la automatización de estos programas de una manera que garantice la transparencia, el debido proceso y “resultados equitativos”.

Sin embargo, lo que la orden no hace es imponer líneas rojas contra las aplicaciones de la tecnología que parecen ser propensas a ser objeto de abuso, como el reconocimiento facial , la vigilancia policial predictiva y las evaluaciones algorítmicas de riesgos en las sentencias penales. Las órdenes ejecutivas tampoco sustituyen a la legislación: solo el Congreso puede otorgar a las autoridades federales nuevos poderes y fondos para regular la industria tecnológica, y solo el Congreso puede imponer nuevas restricciones sobre cómo los estados gastan los dólares federales en sistemas de inteligencia artificial.

El daño de la IA a los servicios públicos ofrece una hoja de ruta sobre cómo regular significativamente la tecnología y los costos de no alcanzarla. Quizás el aprendizaje más crítico es la necesidad de establecer zonas prohibidas: prohibiciones de aplicaciones de IA que representan un riesgo inaceptable para los derechos de las personas. A medida que los responsables políticos de la UE ultimen el texto de la Ley de IA en las próximas semanas, tendrán una última oportunidad para adaptar la prohibición de puntuación social de la regulación a los abusos facilitados por la IA en los servicios públicos. Un puñado de ciudades estadounidenses han prohibido a sus agencias gubernamentales el uso del reconocimiento facial, pero siguen siendo la excepción a pesar de la creciente evidencia del papel de la tecnología en los arrestos injustos .

Estas prohibiciones también deben considerarse cuando los riesgos que plantea la IA no pueden mitigarse lo suficiente mediante la debida diligencia, la supervisión humana y otras salvaguardias. El desastroso lanzamiento en Arkansas de un algoritmo para asignar atención domiciliaria es un ejemplo de ello. En respuesta a los desafíos legales, el estado estableció un nuevo sistema que seguía dependiendo de un algoritmo para evaluar la elegibilidad, pero requería que los funcionarios del departamento de salud verificaran sus evaluaciones y las modificaran según fuera necesario. Pero persistieron los recortes arbitrarios en las horas de atención domiciliaria de las personas : una mujer de 71 años con discapacidad que demandó al estado por reducir sus horas dijo que pasaba hambre, se sentaba con ropa empapada de orina y, como resultado, faltaba a citas médicas. A pesar de salvaguardias adicionales, el objetivo primordial del sistema asistido por algoritmos siguió siendo el mismo: reducir costos mediante la reducción del soporte.

Para los sistemas de IA que plantean riesgos manejables, una regulación significativa requerirá salvaguardias que impulsen un escrutinio de las opciones políticas que dan forma a cómo se diseñan e implementan estos sistemas. Los procesos bien intencionados para reducir el sesgo algorítmico o los errores técnicos pueden distraer la atención de la necesidad de abordar los factores estructurales de la discriminación y la injusticia. Los efectos catastróficos del Crédito Universal del Reino Unido y del algoritmo de Medicaid de Arkansas son tanto una consecuencia de los recortes al sistema de prestaciones impulsados por la austeridad como de una dependencia excesiva de la tecnología. El algoritmo de seguimiento de las bajas por enfermedad en España, dicen los inspectores médicos , no es una solución a la escasez de personal que están experimentando desde hace mucho tiempo.

De Liban, el abogado de Legal Aid, dijo que tratar de arreglar el algoritmo a veces distrae la atención de la necesidad de arreglar el problema político subyacente. La toma de decisiones algorítmica está predispuesta a infligir daño si se introduce en el apoyo a la clasificación en un sistema de prestaciones que carece crónicamente de fondos suficientes y está diseñado para tratar a los beneficiarios como sospechosos en lugar de como titulares de derechos. Por el contrario, es más probable que la automatización de beneficios promueva la transparencia, el debido proceso y “resultados equitativos” si se basa en inversiones a largo plazo para aumentar los niveles de beneficios , simplificar la inscripción y mejorar las condiciones laborales de los cuidadores y trabajadores sociales .

Los formuladores de políticas no deben permitir que las exageraciones sobre la IA generativa o las especulaciones sobre sus riesgos existenciales los distraigan de la urgente tarea de abordar los daños de los sistemas de IA que ya están entre nosotros. No prestar atención a las lecciones del pasado y del presente de la IA nos condenará a repetir los mismos errores.